Dissertationspreis der Otto-von-Guericke-Universität für Logistiker Dr. Sebastian Lang

22.11.2023 -

22.11.2023 -

Die Otto-von-Guericke-Universität Magdeburg hat auf dem Akademischen Festakt herausragende Wissenschaftlerinnen und Wissenschaftler für ihre exzellenten Leistungen in Forschung und Lehre ausgezeichnet. Die Festveranstaltung in der Johanniskirche wird traditionell anlässlich des Geburtstags ihres Namenspatrons im November gefeiert und bildet in diesem Jahr den Abschluss des Jubiläumsjahres der Uni, die 2023 ihre Gründung vor 30 Jahren feierte.

Dr. Sebastian Lang vom Institut für Logistik und Materialflusstechnik wurde für seine exzellente Forschungsleistungen im Rahmen seiner Dissertation " Methoden des bestärkenden Lernens für die Produktionsablaufplanung“ ausgezeichnet.

Herzlichen Glückwunsch!

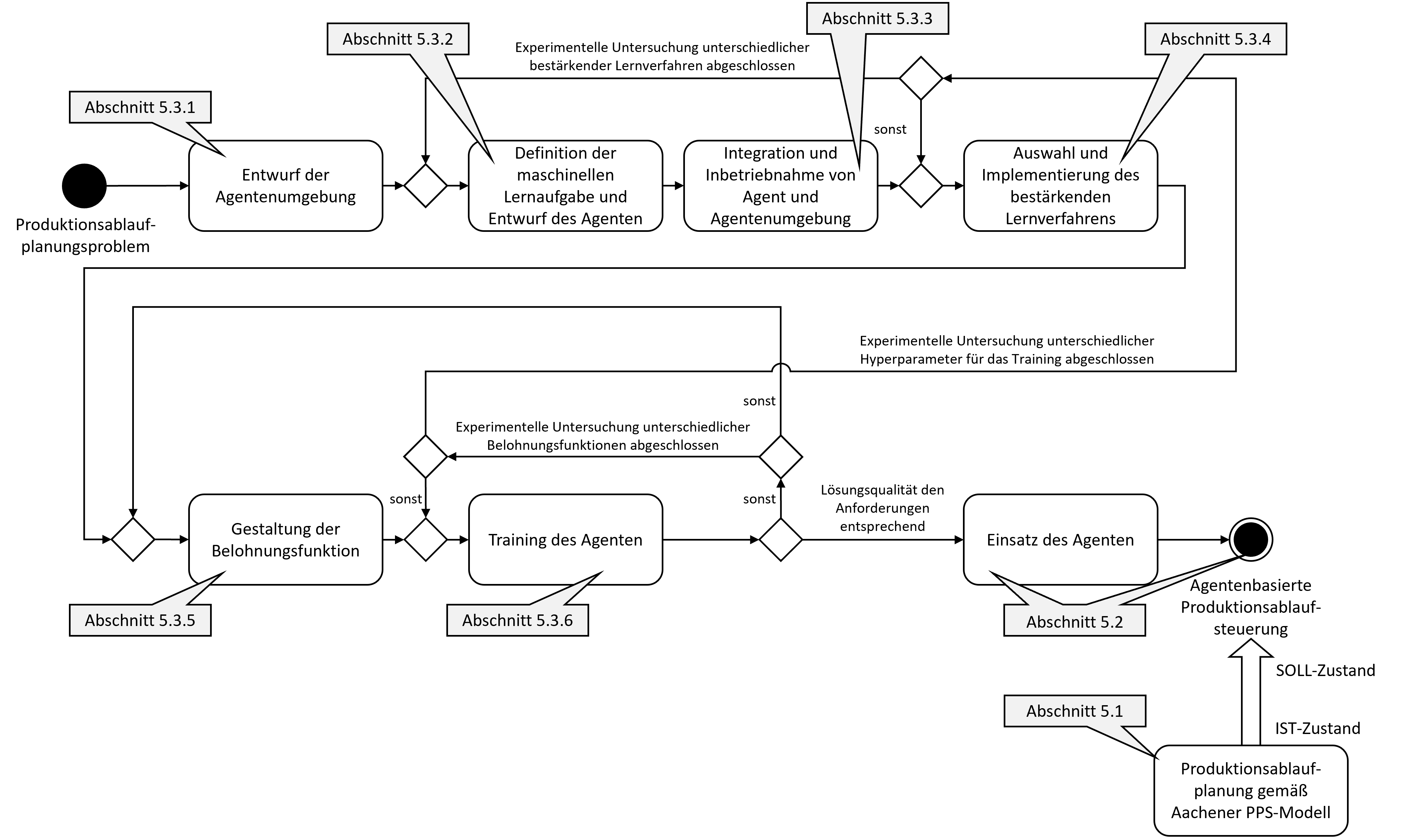

Im Rahmen der Arbeit wurde eine Methode zur Adaption, Integration und Anwendung von bestärkenden Lernverfahren (Reinforcement Learning) für die Produktionsablaufplanung entwickelt. Hierbei wurde die Methoden anhand von typischen Problemstellungen der Produktionsablaufplanung hergeleitet und evaluiert.

Die Produktionsablaufplanung ist eine Kernaufgabe der Produktion und Logistik, bei welcher Aufträge auf Ressourcen so verteilt und in Reihenfolge sortiert werden müssen, dass geforderte Nebenbedingungen der Planung (z. B. maximale Durchlaufzeit, Mindestdurchsatz, Termintreue, etc.) erfüllt werden. Entsprechende Optimierungsprobleme sind meist NP-schwer, wodurch eine optimale Lösung gewöhnlich nicht unter wirtschaftlichen Bedingungen erzielbar ist. In der Industrie werden stattdessen Prioritätsregeln, Heuristiken oder Metaheuristiken verwendet, die entweder zeiteffizient zu Lasten der Lösungsgüte rechnen oder qualitativ hochwertige Lösungen unter hohem Rechenaufwand erzeugen.

Das bestärkende Lernen ist eine Unterart des maschinellen Lernens und repräsentiert eine weitere Klasse potenzieller Lösungsstrategien. Die Methoden des bestärkenden Lernens eint insbesondere ein Vorteil gegenüber dem konventionellen (überwachten) maschinellen Lernen: Sie benötigen für eine Modelleingabe keine bekannte Ausgabe, um die Lösung eines Problems zu erlernen. Stattdessen werden Modellausgaben durch eine Belohnungsfunktion bewertet, sodass mittels Versuch und Irrtum Lernsignale generiert werden. Bestärkende Lernverfahren haben in jüngster Vergangenheit bei Problemen Erfolge erzielt, die Sequenzen von Entscheidungen in nichtdeterministischen Umgebungen erfordern. Hierzu zählen insbesondere klassische Brettspiele sowie zwei- und dreidimensionalen Computerspiele. Probleme der Produktionsablaufplanung sind insoweit vergleichbar, als dass sie sich ebenfalls als stufenartige Entscheidungsketten modellieren lassen. Trotz der diskutierten Vorteile ist der Einsatz von bestärkenden Lernverfahren für die Produktionsablaufplanung noch kaum beforscht. Obgleich sich bereits einige Forschungsarbeiten mit Methoden des bestärkenden Lernens für bestimmte Probleme der Produktionsablaufplanung beschäftigen, existiert bisher kaum verallgemeinertes und formalisiertes Wissen hinsichtlich der Anwendung des bestärkenden Lernens für die Produktionsablaufplanung. Die in der Arbeit dargelegte Methodeerhebt den Anspruch genau diese Forschungslücke zu schließen.

Bild: Das Vorgehensmodell fasst einen großen Teil der entwickelten Methode zusammen

Weitere Informationen zum Thema Selbstbestärkendes Lernen

Projekte

Publikationen

Lang, S., Kuetgens, M., Reichardt, P. und Reggelin, T. (2021): Modeling Production Scheduling Problems as Reinforcement Learning Environments based on Discrete-Event Simulation and OpenAI Gym. In: IFAC-PapersOnLine 54 (1). S. 793–798.

Lang, S., Reggelin, T., Müller, M. und Nahhas, A. (2021): Open-Source Discrete-Event Simulation Software for Applications in Production and Logistics: An Alternative to Commercial Tools? In: Procedia Computer Science 180, S. 978–987.

o Lang, S., Reggelin, T., Schmidt, J., Müller, M. und Nahhas, A. (2021): NeuroEvolution of Augmenting Topologies for Solving a Two-Stage Hybrid Flow Shop Scheduling Problem: A Comparison of Different Solution Strategies. In: Expert Systems with Applications 172. Aufsatznummer 114666.

o Lang, S., Lanzerath, N., Reggelin, T., Müller, M. und Behrendt, F. (2020): Integration of Deep Reinforcement Learning and Discrete-Event Simulation for Real-Time Scheduling of a Flexible Job-Shop Production. In: Bae, K.-H. G., Feng, B., Kim, S., Lazarova-Molnar, S., Zheng, Z., Roeder, T. und Thiesing, R. (Hg.): Proceedings of the 2020 Winter Simulation Conference (WSC'20). Orlando, FL, USA, 14.-18. Dezember. Piscataway, NJ, USA: IEEE. S. 3057–3068.

o Lang, S., Reggelin, T., Behrendt, F. und Nahhas, A. (2020): Evolving Neural Networks to Solve a Two-Stage Hybrid Flow Shop Scheduling Problem with Family Setup Times. In: Proceedings of the 53rd Hawaii International Conference on System Sciences (HICSS 2020). Wailea, HI, USA, 07.-10. Januar. Honolulu, HI, USA: University of Hawaii at Manoa. S. 1298–1307.

o Lang, S., Schenk, M. und Reggelin, T. (2019). Towards Learning- and Knowledge-Based Methods of Artificial Intelligence for Short-Term Operative Planning Tasks in Production and Logistics: Research Idea and Framework. In: IFAC-PapersOnLine 52 (13). S. 2716–2721.